斯坦福大学李飞飞团队在机器人全身移动控制领域取得了重要进展| 斯坦福大学 x 星海图:助力推出全身移动操作家务机器人套件

【ZiDongHua之“自动化学院派”收录关键词:星海图 斯坦福大学 机器人 具身智能机器人 】

开发者生态|斯坦福大学x星海图:助力推出全身移动操作家务机器人套件

01

家庭场景需要怎样的机器人?

What Kind of Robots Do Family Scenes Need?

想让机器人真正“融入”家庭,成为人类的生活助手,绝非易事。在实验室中,移动操作机器人或许能精准抓取物品或完成简单指令,但当场景切换到真实家庭环境——比如需要一边开门一边搬运重物、整理不同高度的储物架,或是清洁马桶等复杂任务时,机器人面临的挑战将指数级上升。

近期,斯坦福大学李飞飞团队在机器人全身移动控制领域取得了重要进展。

项目网站:https://behavior-robot-suite.github.io

斯坦福团队基于针对当前机器人动作基准的分析发现,机器人对于家庭任务的成功执行依赖于三大核心能力:

1.双手协调能力:搬运大件物品或整理衣物时,双机械臂需紧密配合,确保物品稳定拿取与放置。

2.稳定且精确的导航能力:长距离移动中避免碰撞,精准定位目标位置,保障高效、安全地到达指定地点。

3.高覆盖范围的末端执行器可达性:家中物品分布在不同高度和空间,机器人必须灵活调整姿态,确保能触及各类物品完成操作。

然而,复杂的硬件设计(如双臂、移动底盘和多自由度躯干)虽然能提供物理支持,却让策略学习变得困难。如何高效采集数据、协调全身动作的模型训练,成为制约机器人落地的关键瓶颈。为此,斯坦福大学李飞飞团队使用星海图机器人本体,推出BRBEHAVIOR Robot Suite(BRS)机器人套件。

该套件基于星海图的全尺寸双臂仿人形机器人R1,结合了低成本全身数采同构遥操作硬件JoyLo和全身视觉运动注意力策略WB-VIMA,在硬件与算法层面实现协同创新,为家庭场景中的机器人全身控制移动操作提供了全新解决方案。

02

BRS机器人套件

BRBEHAVIOR Robot Suite

BRS突破一:低成本遥操作数据采集方案JoyLo

数据采集是机器人学习的基础,但传统数采方法或依赖昂贵的数采设备,或操作复杂且难以协调全身动作。为实现高自由度移动机械臂的无缝控制,并促进下游策略学习的数据采集,斯坦福团队构建出了低成本全身遥操作数采设备JoyLo(Joy-Con on Low-Cost Kinematic-Twin Arms),并使用JoyLo实现对星海图R1机器人的全身控制。

BRS硬件系统概览。左侧:BRS中使用的是带有灵活躯干的轮式双臂操作机器人Galaxea R1。右侧:专为通用性而设计的低成本全身遥操作界面JoyLo。

JoyLo的硬件使用任天堂Switch手柄结合3D打印的双臂连杆,实现针对星海图R1机器人3自由度底盘、4自由度躯干、14自由度双臂及执行器的低成本全身控制。这套方案的优势在于:

●高效的全身控制:

用户可以通过小体积的手柄和双臂连杆控制星海图仿人形机器人R1的移动底盘、躯干和双臂,能够像玩主机游戏一样轻松控制复杂的机器人姿态和动作。

●直观的交互反馈:

多样的触觉反馈(如手柄震动)可以实时提示用户操作状态,如抓取成功或碰撞预警,从而进一步升级实时的交互反馈。

●高质量的真机数据:

与基于VR及Apple Vision Pro的遥操作方案相对比,JoyLo采集数据的任务成功率比VR遥操作方案高出5倍、平均完成时间比VR遥操作方案低23%。特别是在复杂及长程任务上,JoyLo方案表现出色,采集到的轨迹可直接用于策略学习,无需复杂的数据后处理过程。

●低成本的结构设计:

整个系统由3D打印的双臂连杆、低成本Dynamixel电机和Joy-Con控制器组成,总成本低于500美元,且模块化设计便于更换组件。

●易于使用的实时控制器:

BRS包含一个直观的、基于Python接口的实时控制器,能将目标关节位置和目标速度转换为控制命令,通过ROS发送给机器人。

用于全身遥操作和数据采集的JoyLo

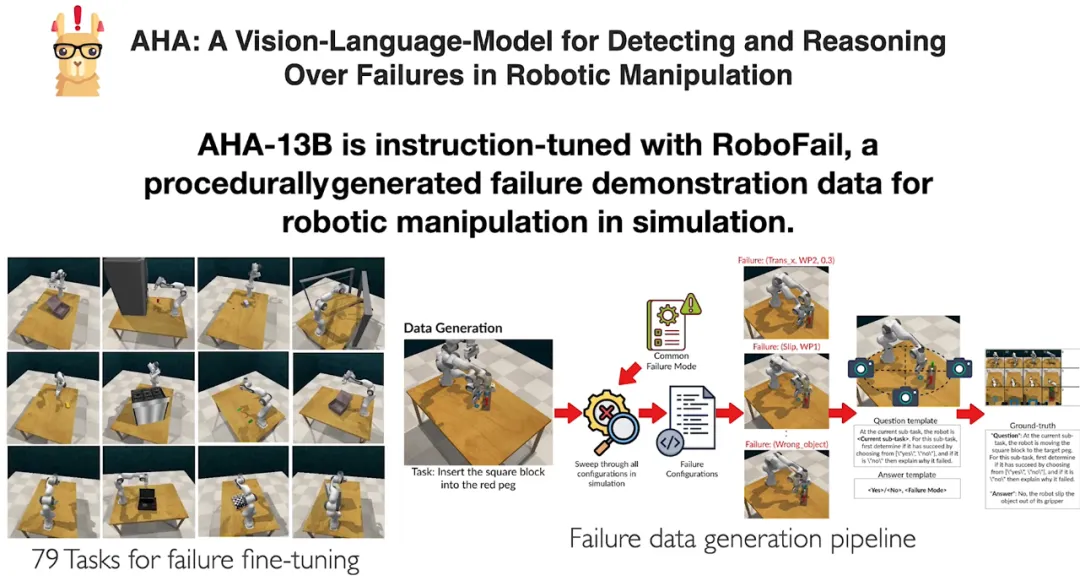

BRS突破二:多层级全身控制算法框架WB-VIMA

解决数采硬件的问题后,如何让机器人自主规划全身动作仍是难题。此前多数方法将机器人全身的关节动作进行“扁平化”预测,忽略层级依赖,导致误差累积(例如底座移动偏差会让机械臂完全抓空)。BRS提出的WB-VIMA算法,通过两大创新解决这一问题:

●自回归全身动作去噪:

利用机器人实体的固有层次结构,先预测底盘移动动作,再基于底盘状态预测躯干姿态,最后协调双臂动作,层层递进确保对全身协调运动进行建模。

●多模态观测注意力机制:

使用以本体为中心的彩色点云和机器人关节位置以及移动底座速度作为观察输入。通过将各模态观察编码为观察令牌,再将当前和先前时间步的观察令牌组装成视觉运动序列,经过因果自注意力机制处理,使策略有效融合多模态信息,避免过拟合单一信息源。

注:WB-VIMA模型架构。WB-VIMA自回归地对空间内的全身动作进行降噪,并使用自注意力动态聚合多模态观察。通过利用机器人体现中的层次相互依赖关系以及多模态感官输入提供的丰富信息,WB-VIMA可以实现有效的全身策略学习。

为验证WB-VIMA的能力,斯坦福团队将RBS套件应用于五项真实家庭场景中,包括:

●倒垃圾:从室内拾取垃圾袋并运送至室外。

●整理货架物品:将地面箱子精准放置到多层货架。

●整理衣物:从衣柜取出外套并平铺至沙发床。

●清洁马桶:开盖擦拭、按压冲水按钮全程自主完成。

●派对后清理房屋:收集餐具并放入洗碗机。

结果显示,BRS成功让机器人胜任这些多样化家务任务,其创新算法WB-VIMA在所有任务表现上全部优于基线方法(包括DP3及基于RGB图像的扩散策略RGBDP)。端到端长程任务成功率比DP3高13倍、比RGBDP高21倍;在平均子任务成功率上,WB-VIMA比DP3高1.6倍、比RGBDP高3.4倍。

不同算法在五项代表性家务活动的成功率。注:“ET”表示整个任务,“ST”表示子任务

WB-VIMA在五项家务任务中的端到端模型演示:

倒垃圾:机器人从客厅拾取垃圾袋→导航至门口→开门→移动到室外垃圾桶

整理货架物品:机器人在储藏室内从地面拾取箱子→移动到四层货架→(根据可用空间)将箱子放置在相应的货架层上

整理衣物:双机械臂配合取出衣架上的外套,平铺在沙发床上

清洁马桶:灵活调整躯干角度,开盖、擦拭、按压冲水按钮一气呵成

派对后清理房屋:机器人按顺序完成从打开洗碗机门→整理桌面餐具→放置餐具进洗碗机→关闭洗碗机门

03

星海图:全方位赋能,探索前沿科技

Galaxea:Empowerment and Exploration

斯坦福团队整套BRS机器人套件均基于星海图R1机器人进行开发,目前论文、代码、硬件设计方案和数据已经全部开源,欢迎全球顶尖的开发者通过访问项目网站(https://behavior-robot-suite.github.io)了解详情。同时,星海图也将持续为开发者提供全方位支持,满足全链路开发需求:

●数据采集:

星海图自研同构遥操作平台R1 Teleop,可以实现与JoyLo硬件同样高效的数据采集效果。星海图R1系列全系仿人形机器人,均可搭配同构遥操作平台,助力开发者完成低成本高效数采工作。

●机器人算法验证:

WB-VIMA的开源框架可无缝接入星海图机器人本体及开发环境,助力开发者快速验证算法,大幅缩短研发周期。

●场景拓展:

不论是家务劳动,还是商业应用,甚至是工业场景,高自由度星海图仿人形通用机器人系列可以支持开发者探索更多复杂的移动操作任务。

无论是高校实验室还是企业研发团队,星海图将持续提供硬件方案、数据支持和开发工具链,助力全球开发者攻克机器人全身控制挑战,让具身智能机器人真正走进千家万户。

我要收藏

点个赞吧

转发分享

评论排行