大幅降低网络能量消耗,为低功耗神经形态系统的发展提供了新思路|中科院自动化所联合西安交大提出注意力脉冲神经网络

【“ZiDongHua”之创新&科技:脉冲神经网络】这项工作将注意力机制融入百万级规模脉冲神经网络,在ImageNet-1K数据集上,首次取得了与传统人工神经网络相当的性能,且理论能效为同等结构人工神经网络的31.8倍。本方法在显著提升任务性能的同时能够大幅降低网络能量消耗,为低功耗神经形态系统的发展提供了新思路。

自动化所联合西安交大提出注意力脉冲神经网络:更低功耗更高性能的类脑模型

近日,中国科学院自动化所脑图谱与类脑智能实验室李国齐研究员与西安交通大学赵广社教授合作在人工智能顶级国际期刊IEEE Transactions on Pattern Analysis and Machine Intelligence(TPAMI)上发表了一篇题为“Attention Spiking Neural Networks”的研究。这项工作将注意力机制融入百万级规模脉冲神经网络,在ImageNet-1K数据集上,首次取得了与传统人工神经网络相当的性能,且理论能效为同等结构人工神经网络的31.8倍。本方法在显著提升任务性能的同时能够大幅降低网络能量消耗,为低功耗神经形态系统的发展提供了新思路。

以传统人工神经网络为代表的深度学习近年来在一些任务上展现出接近或超越人类的能力。在取得这些成就的同时,人类也付出了海量的能耗代价。而人脑能够以极低地能耗高效完成相同或更复杂的任务。如何使得机器智能像人脑一样高效工作是研究者们孜孜以求的目标。基于脉冲神经网络的神经形态计算提供了一种极具吸引力的传统人工智能的低能耗替代方案。脉冲神经元模拟了生物神经元中的复杂时空动态,其表达能力在理论上强于现有的人工神经元。同时,脉冲神经元继承了生物神经元中的脉冲通信方式,这也是脉冲神经网络实现低功耗的关键。一方面,在神经形态系统中只需要执行低能耗的突触加法;另一方面,事件驱动特性使得只有脉冲神经元发放脉冲时神经形态系统才会触发计算。因此,如何以低脉冲发放率实现高任务性能是神经形态计算中的一个重要问题。人脑可以自然而有效地在复杂场景中找到重要信息,这被称为注意力机制。注意力机制已被广泛应用于深度学习中,并取得了显著的效果。然而在神经形态计算领域的应用还极具挑战性。

为了将注意力机制融入脉冲神经网络中,有三个基础问题需要考虑。首先,脉冲神经网络高能效的关键是以脉冲通信为基础的事件驱动特性,注意力机制不能破坏这种特性。其次,脉冲神经网络应用场景广泛,需要有多样性的设计以保证其在各种场景中的有效性。最后,二进制脉冲通信使得深度脉冲神经网络容易出现由梯度消失或爆炸带来的性能退化问题,注意力机制的加入至少不应加剧退化问题。

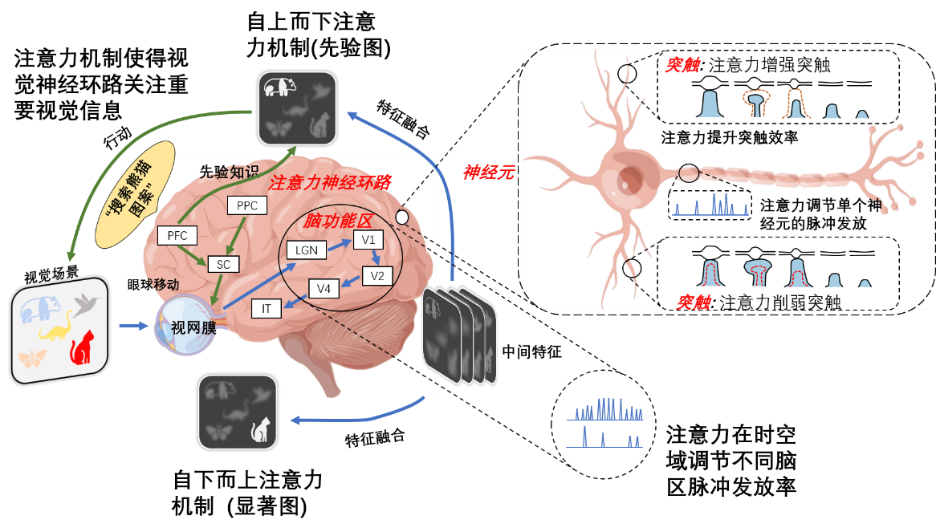

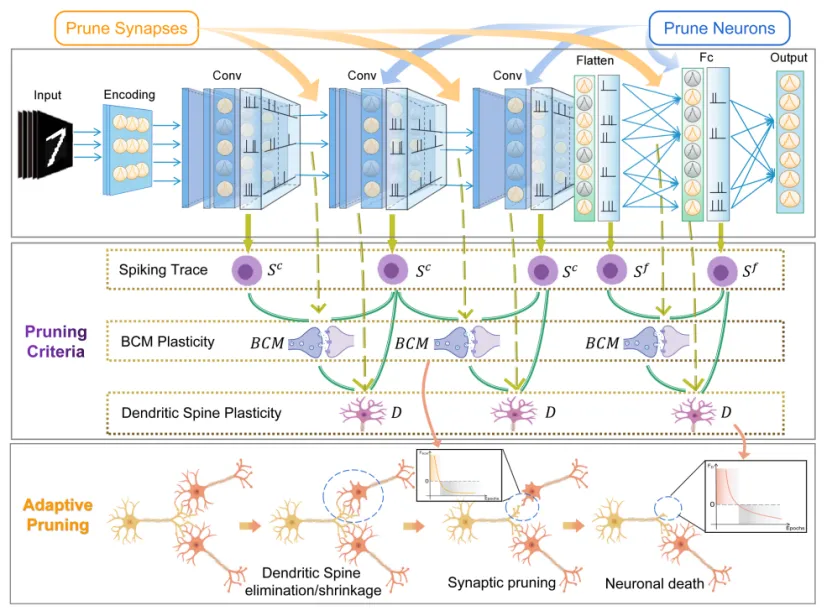

图1. 大脑在多层级结构上存在注意力机制

如图1所示,人脑中注意力的功能实现主要体现在对不同脑区或神经元脉冲发放的调节。受此启发,该研究通过注意力机制来优化脉冲神经网络内部的膜电势分布,关注重要特征并抑制不必要的特征,进而起到调节脉冲发放的作用。网络架构如图2所示。

图2. 多维度注意力脉冲神经网络,注意力机制被用来调节膜电势分布

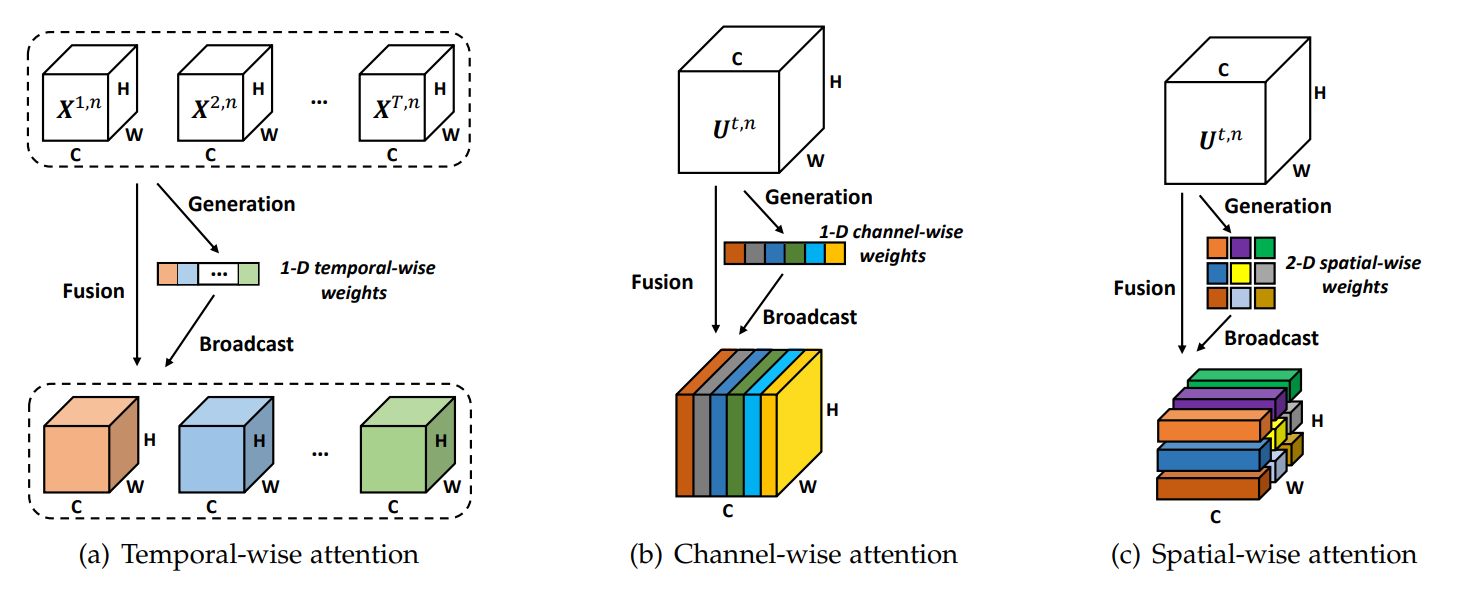

进一步地,为了使注意力脉冲神经网络适应于各种应用场景,如图3所示,该研究融合了时间、通道和空间三个维度,以学习“何时”、“什么”、“哪里”是重要的。

图3. 时间、通道、空间维度注意力机制示意图

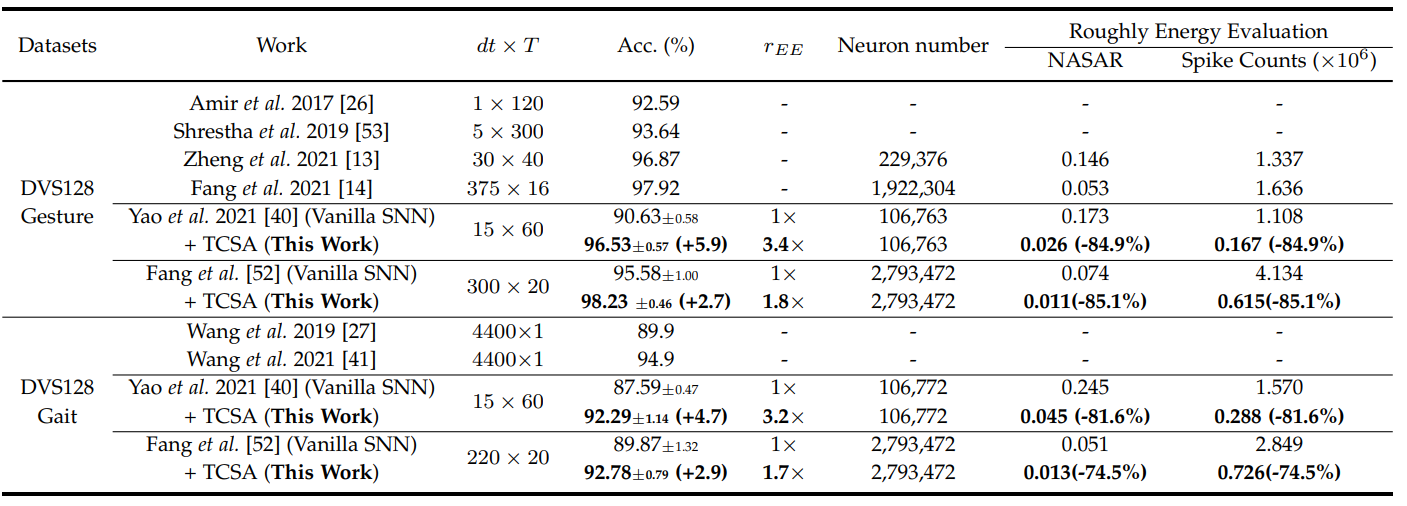

研究团队在基于事件的动作识别数据集以及静态图像分类数据集ImageNet-1K上对提出的多维度注意力脉冲神经网络进行了实验。实验表明注意力模块的加入不仅帮助脉冲神经网络在性能上有显著提升,网络中的脉冲数量也能大大降低,从而降低模型能耗。在DVS128 Gait数据集上,多维度注意力模块能够使得原始脉冲神经网络降低81.6%的脉冲发放,同时带来4.7%的性能提升(表1)。在ImageNet-1K数据集上,注意力脉冲神经网络首次取得了与传统人工神经网络相当的性能,且理论能效为同等结构人工神经网络的31.8倍(表2)。

表1. 在DVS128 Gesture/Gait上结果性能对比

表2. 在ImageNet-1K上结果性能对比

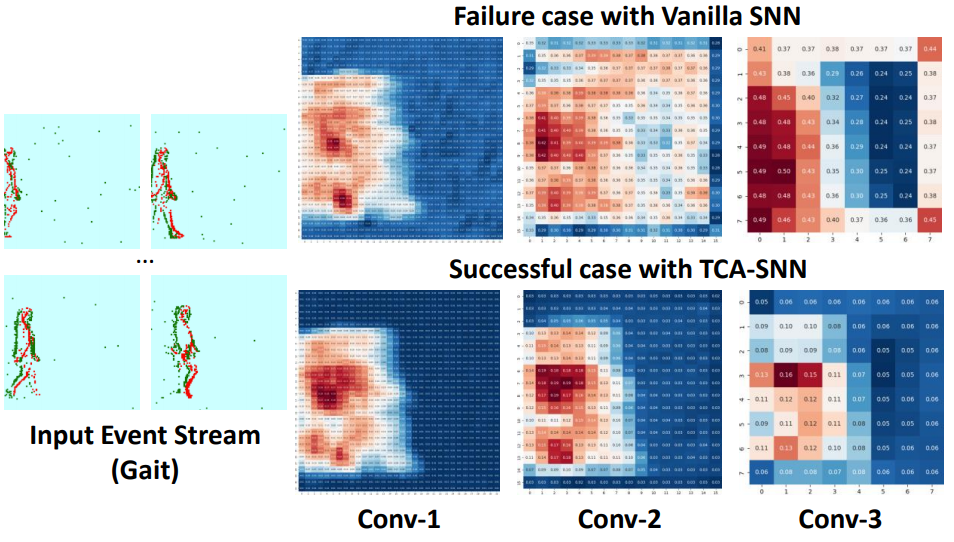

该研究还提出了一种新的可视化方法用来分析为什么所提出的注意力模块能够在降低脉冲发放的同时提升网络性能。如图4、图5所示,加入了注意力机制的脉冲神经网络在专注重要信息的同时,能够抑制不重要的背景噪声信息(特征图中的每个像素点代表一个神经元发放率。颜色越红代表发放率越大;越蓝代表发放率越小)。而在所有的特征图中,噪声特征图或神经元中的脉冲发放率都很高。因此抑制噪声信息能够显著降低网络中的脉冲发放。

图4. Gait数据集中的案例分析

图5. DVS128 Gait数据集中的脉冲响应。注意力机制能够显著抑制背景噪声

进一步,该研究通过块动态等距理论证明将所提出的注意力模块加入到深度脉冲神经网络中仍然能实现动态等距。也就是,注意力模块在深度脉冲神经网络中不会引起性能退化。

综上,本研究工作探索了如何在脉冲神经网络中使用注意力机制,发现通过将注意力机制作为辅助模块插入到脉冲神经网络中,能够在大幅度降低网络脉冲发放的同时显著提升任务性能。通过可视化原始和注意力脉冲神经网络的脉冲响应可知,注意力机制能帮助原始网络在专注重要信息的同时抑制噪声信息,而噪声通道或神经元中包含了大量的脉冲。因此,在基于脉冲神经网络的神经形态计算中,能够实现像人脑一样以更低的能耗获得更好的性能。

论文第一作者为西安交大博士生姚满,通讯作者为中国科学院自动化所李国齐研究员。中国科学院自动化所徐波研究员、西安交通大学赵广社教授、北京大学田永鸿教授和清华大学硕士生张恒煜、博士生胡一凡、邓磊助理教授是论文共同作者。相关工作得到了北京市杰出青年基金、国家自然科学基金委重点项目、区域创新联合重点项目等基金项目的支持。

论文地址:

https://ieeexplore.ieee.org/document/10032591

本文代码已开源至SpikingJelly框架:

https://github.com/fangwei123456/spikingjelly/pull/329

评论排行